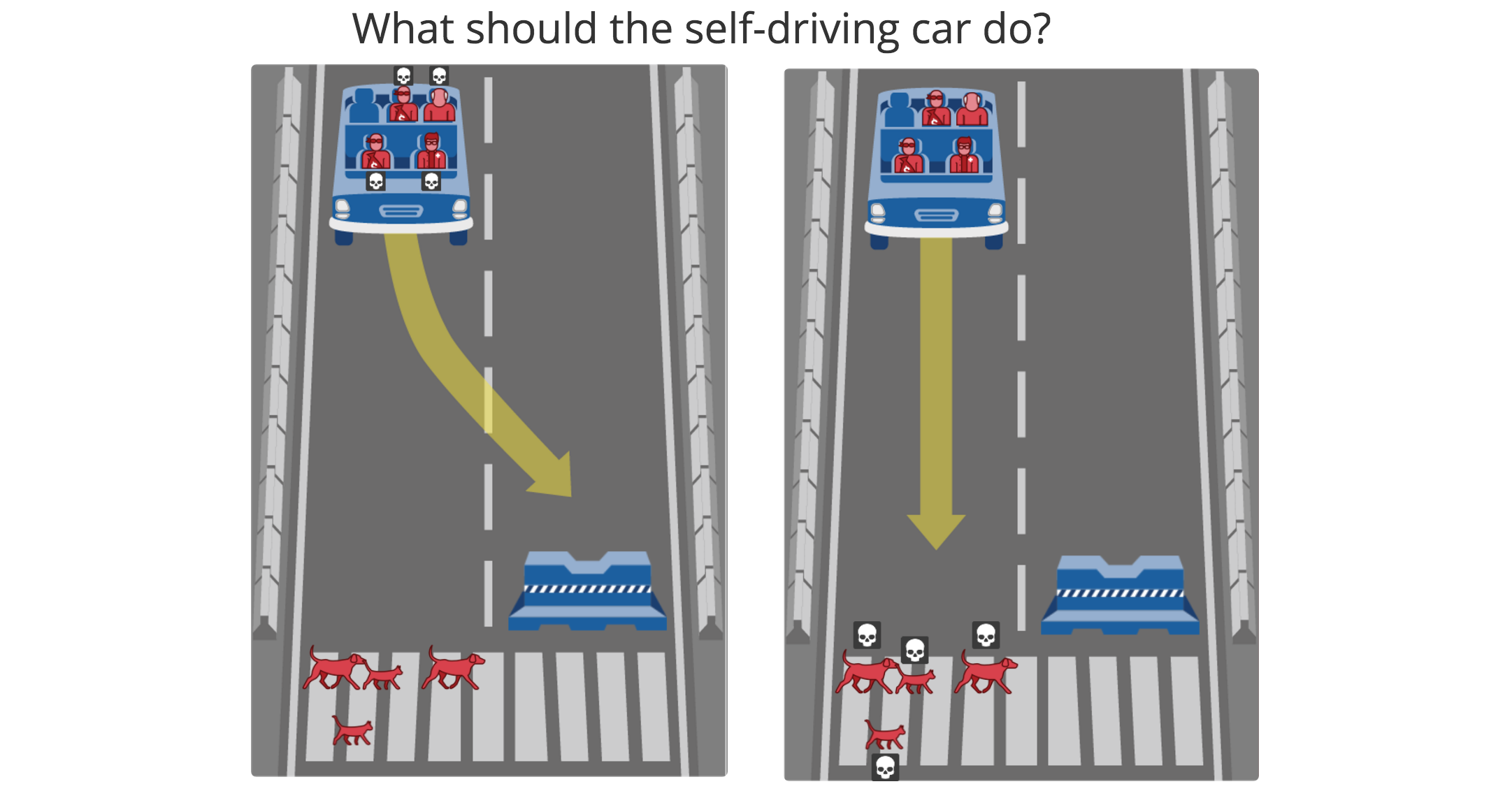

Hace meses jugué (sí, jugué) a http://moralmachine.mit.edu/hl/es. Me confronté cara a cara con el verdadero dilema que presentaba a la hora de programar el algoritmo de decisión de un vehículo autónomo. El test termina mostrando un resultado de tus preferencias, confrontado con la media.

Me dio la sensación de que se mezcla tanto la parte ética (racional) como la parte moral (racional-emocional). Y creo que la complejidad radica justo aquí… ética vs moral. ¿Es lo mismo o es diferente? He leído wikipedia, blogs, etc. La cosa no es tan clara. Tiene pequeñas diferencias y encima se contradicen entre sí las publicaciones. Pero en este caso me quedaré con la definición de: https://psicologiaymente.net/psicologia/diferencias-etica-moral#!

“La moral se encarga de determinar qué conductas son adecuadas y cuáles no en un contexto determinado, mientras que la ética se refiere a los principios generales que definen qué comportamientos son beneficiosos para todas las personas.”

Ahora, volvamos al “juego” de MoralMachine. El report final me mostró mi preferencia personal de cuál sería la ética a adoptar para el algoritmo de vehículo autónomo. Más o menos coincidentes con la media. Pero creo que el resultado habría sido completamente otro si la aplicación me hubiera preguntado ‘dónde estoy yo o personas que me importan’ en cada situación. Intuyo que habría tomado la decisión más desde lo moral.

Curiosamente, creo que para que sea lo más ético… tenemos que acallar esa parte de moral individual. Y es por eso que creo que se nos hace tan complicado dar con una ética universal. Sabemos lo que debería pasar… pero no siempre queremos que sea así cuando sentimos implicación directa.

Recientemente, un responsable de Marketing de un fabricante de automóvil muy conocido dijo: (aunque os pueda sonar poco ético) “nosotros protegeremos siempre a los ocupantes del vehículo”. Honestamente, creo que fue muy sincero. Reconoció que era la única manera de incrementar las ventas de sus vehículos autónomos en el futuro. Defendió el derecho a ser “poco ético” a cambio de beneficio, si la regulación es libre. ¿no os suena al caso de IG Farben? Pero… seguro aceptareis esto… e incluso preferiréis montar en un vehículo suyo que en uno de otro, ¿verdad?

Porque… aunque éticamente sea justo salvar a otras vidas sacrificándose personalmente, nadie quiere morir. La persona que decide pagar el vehículo o subir en él, quiere sentirse 100% protegida. Es el instinto con el que nacemos ¿no? Y si uno decide sacrificarse… que sea la decisión de esa persona y no de la máquina. ¿Acaso no consiste en esto la libertad de elección? Sí, justo uno de los derechos de ser humano. No respetar este derecho… podemos llegar a decir paradójicamente que lo que era ético… no es ético. ¿Cierto?

En fin… un tema muy pero muy complejo. Igual podemos llegar a definir lo que debería ser, pero no necesariamente va a coincidir con lo queremos que sea. Espero que la ciudad sea lo más smart (inteligente) posible para que las máquinas no tengan que llegar a aplicar la ética. Mientras tanto… igual es interesante preguntarnos si aceptaremos mejor la decisión tomada por una máquina o por un ser humano, cuando se trata de no salvar vidas (a cambio de salvar otras).

A los que aún no hayan entrado a http://moralmachine.mit.edu/hl/es… os animo a hacerlo. Merece la pena.

Siempre he pensado que este es el gran obstáculo para que el coche autónomo avance. Dicho a lo bestia y yendo al extremo último: alguien tiene el poder de decidir a quién matar. Me echo a temblar.

ResponderEliminar